- Mi az AI Hacking?

- Hogyan használják a mesterséges intelligenciát a kiberbűnözéshez?

- Példák az AI kibertámadásokra

- Hogyan lehet visszaélni a mesterséges intelligenciával rosszindulatú programok kifejlesztésére: Egy OPSWAT szakértői elemzés

- Hogyan védekezzünk az AI-alapú kibertámadások ellen?

- Gyakran ismételt kérdések (GYIK)

Mi az AI Hacking?

Az AI hacking a mesterséges intelligencia felhasználása a kibertámadások fokozására vagy automatizálására. Lehetővé teszi a fenyegető szereplők számára, hogy minimális kézi erőfeszítéssel kódot generáljanak, rendszereket elemezzenek és kikerüljék a védelmet.

A mesterséges intelligencia modellek, különösen a nagy nyelvi modellek (LLM) gyorsabbá, olcsóbbá és a kevésbé tapasztalt hackerek számára is elérhetőbbé teszik a támadások fejlesztését. Az eredmény a mesterséges intelligencia alapú támadások új csoportja, amely gyorsabb, jobban skálázható, és gyakran nehezebb a hagyományos védekezéssel megállítani.

Mi az az AI Hacker?

A mesterséges intelligenciát használó hacker olyan fenyegető szereplő, aki mesterséges intelligenciát használ kibertámadások automatizálására, fokozására vagy skálázására. Az AI hackerek gépi tanulási modelleket, generatív AI-t és autonóm ágenseket használnak a biztonsági ellenőrzések megkerülésére, rendkívül meggyőző adathalász-támadások kidolgozására és a szoftver sebezhetőségének széles körű kihasználására.

Ezek a támadók lehetnek mind a mesterséges intelligencia eszközöket használó emberi operátorok, mind a félautonóm rendszerek, amelyek minimális emberi beavatkozással hajtják végre a feladatokat. A mesterséges intelligenciát használó emberi támadók olyan valós személyek - bűnözők, script kiddies, hacktivisták vagy nemzetállami szereplők -, akik mesterséges intelligenciamodelleket használnak támadási képességeik növelésére.

Az autonóm hacker-ügynökök olyan mesterséges intelligencia által vezérelt munkafolyamatok, amelyek minimális felügyelet mellett képesek láncolni a feladatokat - például felderítést, hasznos teher generálását és kitérést. Bár ezek az ügynökök még mindig az ember által meghatározott célok által vezéreltek, elindításuk után félig függetlenül működhetnek, és a kézi eszközöknél hatékonyabban hajtanak végre többlépcsős támadásokat.

Hogyan használják a mesterséges intelligenciát a kiberbűnözéshez?

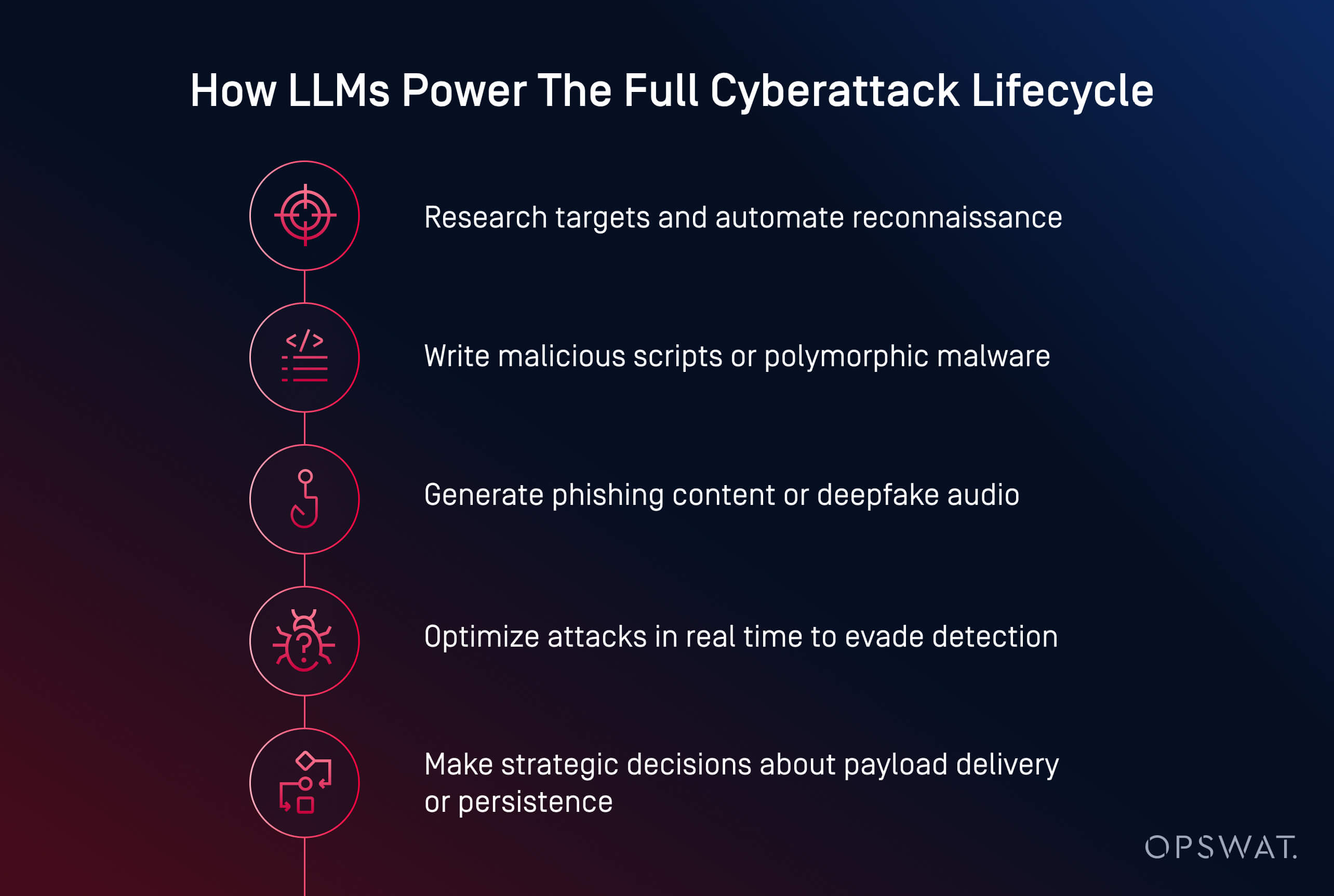

A mesterséges intelligenciát használó fenyegető szereplők ma már gyorsabb, intelligensebb és alkalmazkodóbb kibertámadásokat indítanak. A rosszindulatú programok létrehozásától az adathalászat automatizálásáig az AI a kiberbűnözést skálázható műveletté alakítja át. Ma már képes rosszindulatú kódot generálni, meggyőző adathalász tartalmakat írni, és akár teljes támadási láncokon keresztül vezetni a támadókat.

A kiberbűnözők több alapvető területen is használják a mesterséges intelligenciát:

- Hasznos teher generálása: Az olyan eszközök, mint a HackerGPT és a WormGPT képesek elhomályosított rosszindulatú programok írására, a kitérési taktikák automatizálására és a szkriptek futtatható fájlokká alakítására. Ezek példák a generatív mesterséges intelligencia támadásokra, amelyeket gyakran láthatunk a mesterséges intelligencia-ügynökökkel végrehajtott kibertámadásokban, ahol a modellek autonóm döntéseket hoznak.

- Társadalmi mérnöki tevékenység: A mesterséges intelligencia valósághű adathalász e-maileket hoz létre, hangokat klónoz, és mély hamisítványokat generál az áldozatok hatékonyabb manipulálása érdekében.

- Felderítés és tervezés: A mesterséges intelligencia felgyorsítja a célpontok kutatását, az infrastruktúra feltérképezését és a sebezhetőség azonosítását.

- Automatizálás méretarányosan: A támadók mesterséges intelligenciát használnak arra, hogy többlépcsős kampányokat indítsanak minimális emberi közreműködéssel.

A Ponemon Intézet szerint a mesterséges intelligenciát már használták olyan zsarolóvírus-kampányokban és adathalász-támadásokban, amelyek jelentős működési zavarokat okoztak, beleértve a hitelesítő adatok ellopását és több mint 300 kiskereskedelmi hely kényszerű leállítását egy 2023-as betörés során.

Számos újonnan kialakuló minta alakítja át a fenyegetések körvonalát:

- A kibertámadások demokratizálódása: A támadásra finomhangolt nyílt forráskódú modellek, mint például a LLaMA, mostantól bárki számára elérhetőek, aki helyi számítási kapacitással rendelkezik.

- Alacsonyabb belépési korlát: Ami korábban szakértői készségeket igényelt, ma már egyszerű utasításokkal és néhány kattintással elvégezhető.

- Fokozott kitérési siker: A mesterséges intelligencia által generált rosszindulatú szoftverek jobban elrejtőznek a statikus felderítés, a homokozó dobozok és még a dinamikus elemzés elől is.

- Malware-as-a-Service (MaaS) modellek: A kiberbűnözők a mesterséges intelligencia képességeit előfizetéses csomagokba csomagolják, megkönnyítve ezzel a komplex támadások méretarányos indítását.

- A mesterséges intelligencia használata valós jogsértések esetén: A Ponemon Institute jelentése szerint a támadók már használtak mesterséges intelligenciát a zsarolóvírus célpontok automatizálására, többek között olyan incidensek során, amelyek jelentős műveletek leállítását kényszerítették ki.

AI-alapú adathalászat és Social Engineering

Az AI-alapú adathalászat és a mesterséges intelligenciával működő social engineering a hagyományos átveréseket olyan méretezhető, személyre szabott támadásokká alakítja át, amelyeket nehezebb felderíteni. A fenyegető szereplők ma már generatív modelleket használnak arra, hogy hihető e-maileket készítsenek, hangokat klónozzanak, és akár hamis videohívásokat is létrehozzanak, hogy manipulálják célpontjaikat.

A hagyományos csalásokkal ellentétben az AI által generált adathalász e-mailek kifinomultak és meggyőzőek. Az olyan eszközök, mint a ChatGPT és a WormGPT olyan üzeneteket állítanak elő, amelyek a belső kommunikációt, az ügyfélszolgálatot vagy a HR-frissítéseket utánozzák. Ha ezeket az e-maileket megsértett adatokkal párosítják, személyre szabottá válnak, és nagyobb valószínűséggel lesznek sikeresek.

A mesterséges intelligencia a social engineering újabb formáit is támogatja:

- A hangklónozó támadások rövid hangminták segítségével utánozzák a vezetőket, hogy sürgős műveleteket, például átutalásokat indítsanak el.

- A Deepfake-támadások videohívásokat vagy távoli találkozókat szimulálnak nagy tétes átverésekhez

Egy nemrégiben történt incidens során a támadók mesterséges intelligencia által generált e-maileket használtak az előnyök igénybevételének időszakában, és HR-esnek adták ki magukat, hogy ellopják a hitelesítő adatokat és hozzáférjenek a munkavállalói adatokhoz. A veszély a bizalom illúziójában rejlik. Ha egy e-mail belsőnek tűnik, a hang ismerősnek hangzik, és a kérés sürgősnek tűnik, még a képzett személyzetet is be lehet csapni.

AI sebezhetőségek felfedezése és kihasználása

A mesterséges intelligencia felgyorsítja a támadók szoftveres sebezhetőségek megtalálását és kihasználását. Ami korábban napokig tartó kézi szondázást igényelt, ma már percek alatt elvégezhető a felderítésre és exploit-generálásra kiképzett gépi tanulási modellek segítségével.

A fenyegető szereplők a mesterséges intelligenciát használják a nyilvános rendszerek sebezhetőségi vizsgálatának automatizálására, a gyenge konfigurációk, elavult szoftverek vagy javítatlan CVE-k azonosítására. A hagyományos eszközökkel ellentétben a mesterséges intelligencia képes értékelni a kitettségi kontextust, hogy segítsen a támadóknak rangsorolni a nagy értékű célpontokat.

Az AI által támogatott gyakori kizsákmányolási taktikák közé tartoznak:

- Automatizált fuzzing a nulladik napi sebezhetőségek gyorsabb feltárásához

- Egyedi szkriptgenerálás távoli kódfuttatáshoz vagy oldalirányú mozgáshoz

- Jelszófeltörés és nyers erővel végrehajtott támadások optimalizálása mintatanulással és valószínűségi modellekkel

- Felderítő botok, amelyek minimális zajjal vizsgálják a hálózatokat a nagy kockázatú eszközök után.

Az olyan generatív modellek, mint a LLaMA, a Mistral vagy a Gemma finomhangolhatók, hogy a rendszerspecifikus tulajdonságok alapján testre szabott hasznos terheléseket, például shellcode-ot vagy injekciós támadásokat generáljanak, gyakran megkerülve a kereskedelmi modellekbe épített védelmi mechanizmusokat.

A tendencia egyértelmű: a mesterséges intelligencia lehetővé teszi a támadók számára, hogy gépi sebességgel fedezzék fel a sebezhetőségeket, és azok alapján cselekedjenek. A Ponemon Intézet szerint a kiberbiztonsági szakemberek 54%-a a kijavítatlan sebezhetőségeket tartja a legfőbb aggodalomra okot adó tényezőnek az AI-alapú támadások korában.

AI-vezérelt malware és zsarolóprogramok

A mesterséges intelligencia által generált rosszindulatú szoftverek térhódítása azt jelenti, hogy a hagyományos védekezés önmagában már nem elég. A támadók ma már olyan eszközökkel rendelkeznek, amelyek gondolkodnak, alkalmazkodnak és kitérnek - gyakran gyorsabban, mint ahogy az emberi védők reagálni tudnak.

A mesterséges intelligenciával támogatott zsarolóvírusok és a polimorf rosszindulatú programok újradefiniálják a kibertámadások fejlődését. A támadók a statikus hasznos terhek írása helyett a mesterséges intelligencia segítségével polimorf rosszindulatú kódokat generálnak, amelyek folyamatosan változnak, hogy elkerüljék a felismerést.

A zsarolóvírus-fenyegetések is fejlődnek. A mesterséges intelligencia segíthet kiválasztani a titkosítandó fájlokat, elemezni a rendszer értékét és meghatározni a detonáció optimális időzítését. Ezek a modellek automatizálhatják a geofencinget, a sandbox megkerülését és a memórián belüli végrehajtást is - olyan technikákat, amelyeket jellemzően a fejlett fenyegető szereplők használnak.

A mesterséges intelligenciával történő adatkiszivárgás dinamikusan alkalmazkodik a felderítés elkerülése érdekében. Az algoritmusok a forgalmi minták elemzésével képesek tömöríteni, titkosítani és lopakodva kinyerni az adatokat, elkerülve az észlelést kiváltó eseményeket. Egyes rosszindulatú programok kezdenek stratégiai döntéseket hozni: a veszélyeztetett környezetben megfigyeltek alapján választják meg, hogy mikor, honnan és hogyan szivárogtassanak ki adatokat.

Példák az AI kibertámadásokra

Az AI kibertámadások már nem csak elméleti jellegűek; már használták őket adatlopásra, a védelmi rendszerek megkerülésére és az emberek megszemélyesítésére.

Az alábbi három figyelemre méltó kategória példái azt mutatják, hogy a támadóknak már nincs szükségük fejlett készségekre ahhoz, hogy komoly károkat okozzanak a kibertámadásokban. A mesterséges intelligencia csökkenti a belépési korlátot, miközben növeli a támadások sebességét, méretét és lopakodó jellegét. A védőknek alkalmazkodniuk kell azáltal, hogy proaktívan tesztelik a mesterséges intelligenciával integrált rendszereket, és olyan védelmi intézkedéseket vezetnek be, amelyek mind a technikai manipulációt, mind az emberi megtévesztést figyelembe veszik.

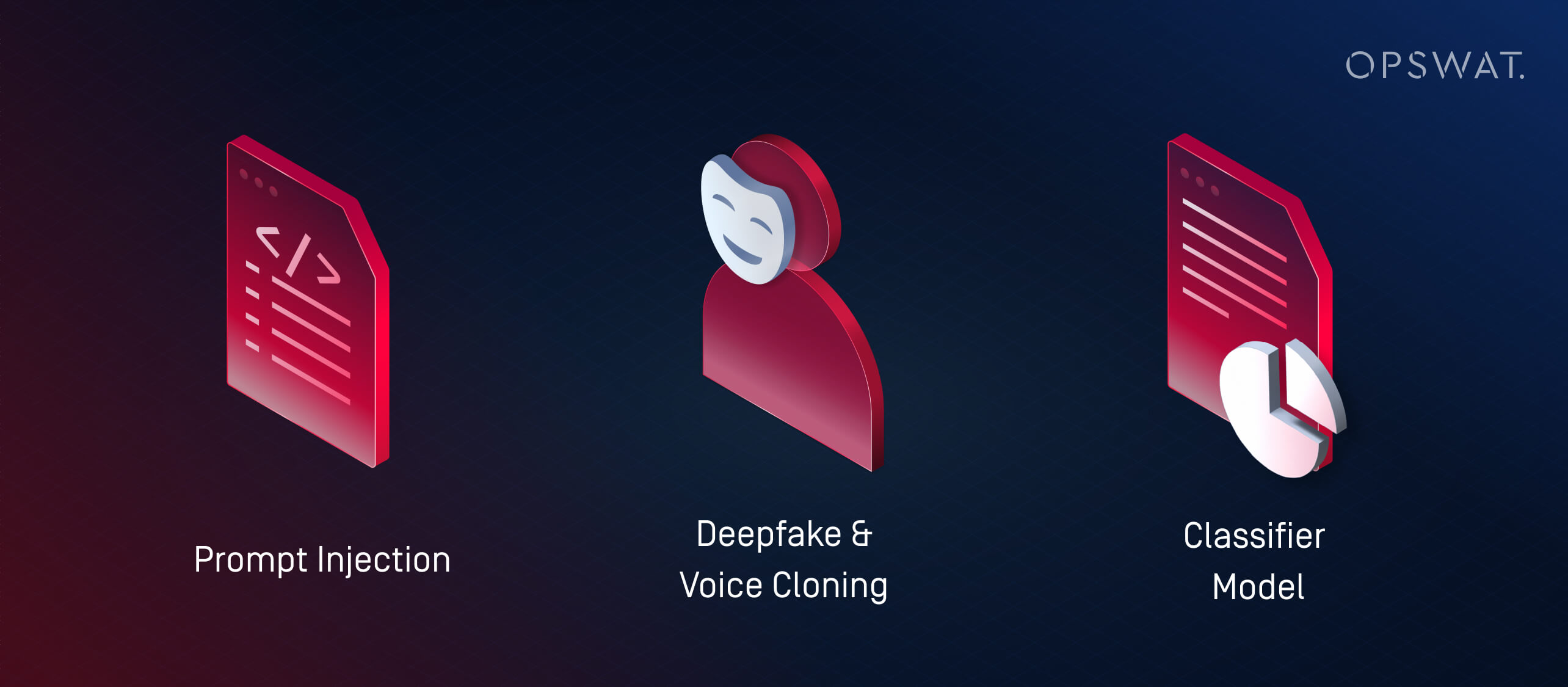

1. Mik azok a Prompt Injection támadások?

A prompt injekció egy olyan technika, amelynek során a támadók az LLM-ek (nagy nyelvi modellek) sebezhetőségeit használják ki azáltal, hogy speciálisan kialakított bemenetekkel táplálják őket, amelyek célja a tervezett viselkedés felülírása. Ezek a támadások kihasználják az LLM-ek értelmezési és rangsorolási módját, gyakran kevés vagy semmilyen hagyományos rosszindulatú programmal.

Ahelyett, hogy a mesterséges intelligenciát külső támadások indítására használnák, a prompt injekció a szervezet saját mesterséges intelligencia rendszereit teszi a kompromittálás akaratlan ügynökeivé. Ha egy LLM-et megfelelő biztosítékok nélkül ágyaznak be olyan eszközökbe, mint a help deskek, chatbotok vagy dokumentumfeldolgozók, a támadó beágyazhat rejtett parancsokat, amelyeket a modell értelmez és cselekszik. Ez a következőket eredményezheti:

- Magánjellegű vagy korlátozott hozzáférésű adatok kiszivárogtatása

- Nem szándékos műveletek végrehajtása (pl. e-mailek küldése, rekordok módosítása)

- A kimenet manipulálása félretájékoztatás terjesztése vagy további intézkedések kiváltása érdekében

Ezek a kockázatok fokozódnak azokban a rendszerekben, ahol több modell továbbítja egymás között az információkat. Például egy dokumentumba ágyazott rosszindulatú felszólítás befolyásolhat egy mesterséges intelligencia-összefoglalót, amely aztán hibás felismeréseket továbbít a következő rendszereknek.

Ahogy a mesterséges intelligencia egyre inkább beépül az üzleti munkafolyamatokba, a támadók egyre inkább ezeket a modelleket veszik célba, hogy veszélyeztessék a bizalmat, adatokat vonjanak ki, vagy manipulálják a döntéseket belülről kifelé.

2. Mik azok a Deepfake és Voice Cloning támadások?

A Deepfake-támadások mesterséges intelligencia által generált hangot vagy videót használnak arra, hogy valós időben megszemélyesítsék az embereket. A social engineering taktikákkal párosítva ezeket az eszközöket csalásra, hitelesítő adatok ellopására és jogosulatlan rendszerelérésre használják.

A hangklónozás különösen veszélyessé vált. Néhány másodpercnyi rögzített beszéddel a fenyegető szereplők olyan hangot tudnak létrehozni, amely utánozza a hangszínt, a tempót és a hanglejtést. Ezeket a klónozott hangokat aztán arra használják, hogy:

- Sürgős hívások során vezetőnek vagy menedzsernek adja ki magát

- Az alkalmazottak átutalásra vagy jelszó-visszaállításra való rávezetése

- A hanghitelesítési rendszerek megkerülése

A Deepfakes ezt egy lépéssel továbbviszi, szintetikus videókat generálva. A fenyegető szereplők szimulálhatnak egy vezérigazgatót egy bizalmas adatokat kérő videóhíváson - vagy megjelenhetnek olyan rögzített klipekben, amelyekben dezinformációt terjesztő politikai változásokat "jelentenek be". A Ponemon Intézet beszámolt egy esetről, amikor a támadók mesterséges intelligencia által generált üzeneteket használtak, amelyekben a HR-esnek adták ki magukat egy vállalat juttatási beiratkozási időszakában, ami hitelesítő adatok ellopásához vezetett.

Ahogy a mesterséges intelligencia-eszközök egyre könnyebben hozzáférhetővé válnak, még a kisstílű fenyegető szereplők is képesek nagy pontosságú megszemélyesítéseket létrehozni. Ezek a támadások a bizalom kihasználásával megkerülik a hagyományos spamszűrőket vagy a végpontok védelmét.

3. Mik azok az osztályozó modell támadások (Adversarial Machine Learning)?

Az osztályozómodell-támadások manipulálják a mesterséges intelligencia rendszer bemeneteit vagy viselkedését, hogy hibás döntéseket kényszerítsenek ki anélkül, hogy feltétlenül rosszindulatú programokat írnának vagy kódot használnának ki. Ezek a taktikák a támadó gépi tanulás tágabb kategóriájába tartoznak.

Két elsődleges stratégia létezik:

- Kitérő támadások: Például olyan rosszindulatú szoftverek, amelyek ártalmatlan fájlokat utánoznak, hogy megkerüljék a vírusirtó motorokat.

- Mérgezéses támadások: A modellt szándékosan torzított adatokon képzik ki vagy finomhangolják, megváltoztatva a fenyegetések észlelésére való képességét.

A szupervizált modellek gyakran "túlilleszkednek": a képzési adatokból meghatározott mintákat tanulnak, és nem veszik észre a csak kis mértékben eltérő támadásokat. A támadók ezt kihasználva olyan eszközöket használnak, mint a WormGPT (egy nyílt forráskódú, támadó feladatokra finomhangolt LLM), hogy hasznos terheket hozzanak létre az ismert észlelési határokon kívül.

Ez a nulladik napi kihasználás gépi tanulási változata.

AI Hacking vs. Hagyományos hackelés: Hacking: A legfontosabb különbségek

A mesterséges intelligencia hackerek a mesterséges intelligenciát a kibertámadások automatizálására, fokozására és skálázására használják. Ezzel szemben a hagyományos hackeléshez gyakran kézi szkriptelésre, mély technikai szakértelemre és jelentős időbefektetésre van szükség. Az alapvető különbség a sebességben, a skálázhatóságban és a hozzáférhetőségben rejlik: most már a kezdő támadók is képesek kifinomult, AI-alapú kibertámadásokat indítani néhány utasítással és egy fogyasztói szintű GPU-val.

Aspect | AI Hacking | Hagyományos hackelés |

|---|---|---|

Sebesség | Közel azonnali automatizálással | Lassabb, kézi szkriptelés |

Képzettségi követelmények | Prompt-alapú; alacsony belépési korlát, de modellel való hozzáférést és hangolást igényel. | Magas; mély műszaki szakértelmet igényel |

Skálázhatóság | Magas - támogatja a többlépcsős támadásokat számos célpont ellen. | Korlátozza az emberi idő és erőfeszítés |

Alkalmazkodóképesség | Dinamikus - a mesterséges intelligencia valós időben módosítja a hasznos terhet és a kitérést. | Statikus vagy félig adaptálható szkriptek |

Támadási vektorok | LLM-ek, mély hamisítványok, osztályozó modell támadások, autonóm ágensek | Rosszindulatú programok, adathalászat, kézi felderítés és kihasználások |

Óvintézkedések | Kiszámíthatatlan lehet; emberi felügyelet nélkül hiányzik a szándék és a kontextus. | Több stratégiai irányítás, de lassabb és kézi vezérlés |

AI visszaélés és ellenséges gépi tanulás

Nem minden mesterséges intelligenciával kapcsolatos fenyegetés magában foglalja a rosszindulatú szoftverek létrehozását - egyesek magukat a mesterséges intelligencia rendszereket veszik célba. A gépi tanulással kapcsolatos ellenséges taktikák, például a prompt injection és a modellmérgezés manipulálhatják az osztályozókat, megkerülhetik a felismerést, vagy megrongálhatják a döntéshozatalt. Mivel a mesterséges intelligencia a biztonsági munkafolyamatok központi elemévé válik, ezek a támadások rávilágítanak a robusztus tesztelés és az emberi felügyelet sürgős szükségességére.

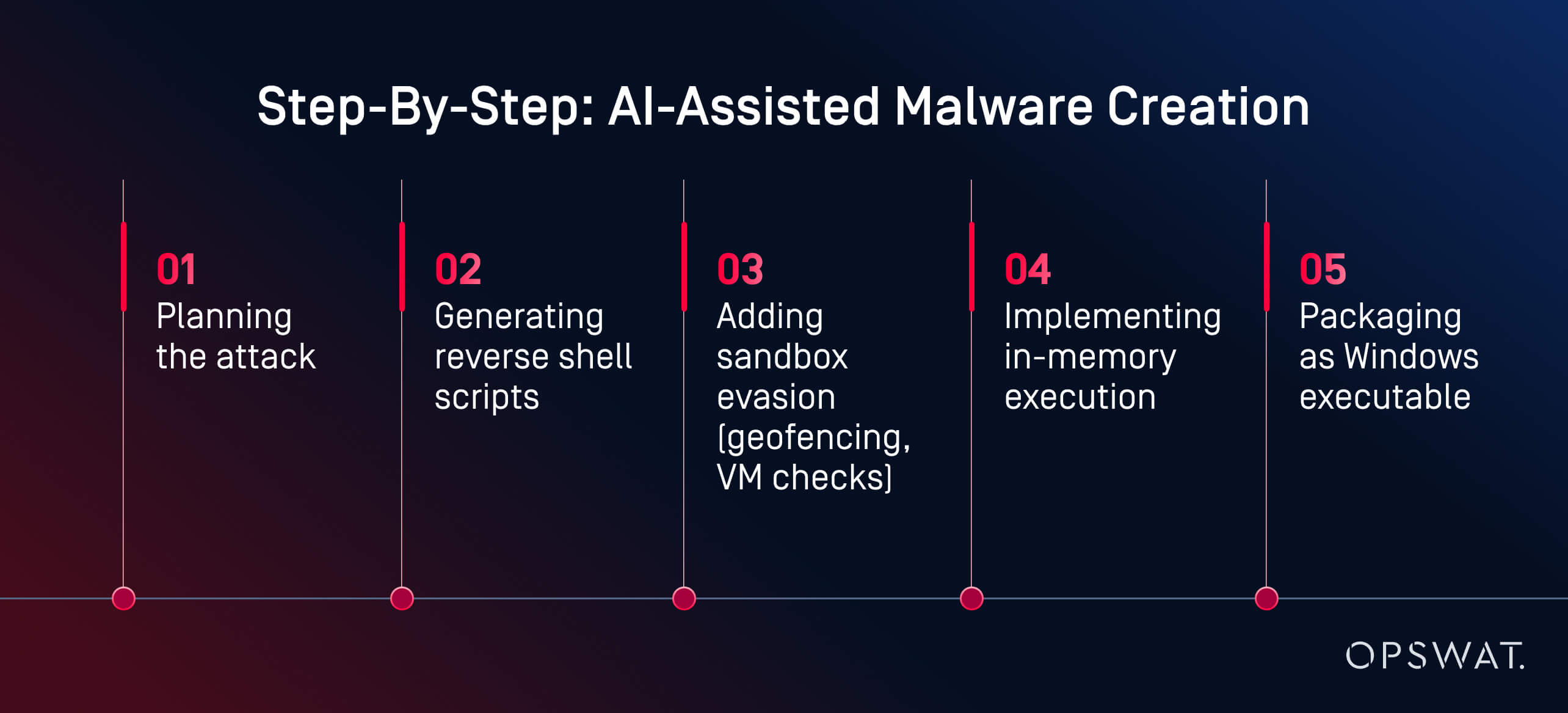

Hogyan lehet visszaélni a mesterséges intelligenciával rosszindulatú programok kifejlesztésére: Egy OPSWAT szakértői elemzés

Ami korábban haladó készségeket igényelt, ma már csak néhány kattintással és utasítással elvégezhető.

Martin Kallas,OPSWAT kiberbiztonsági szakértője egy élő kísérlet során bemutatta, hogy a mesterséges intelligencia eszközeivel hogyan lehet gyorsan, olcsón és fejlett ismeretek nélkül kitérő rosszindulatú szoftvereket létrehozni. A HackerGPT segítségével Martin kevesebb mint két óra alatt létrehozott egy teljes kártevő láncot. A modell minden fázison végigvezette őt:

"A mesterséges intelligencia minden fázison végigvezetett: tervezés, elfedés, kitérés és végrehajtás" - magyarázta Martin. Az eredmény "... egy AI által generált hasznos teher volt, amely a VirusTotal 63 vírusirtó motorjából 60-nak sikerült elkerülnie az észlelést". A viselkedéselemzés és a sandboxing szintén nem jelezte, hogy rosszindulatú lenne.

Ez nem egy nemzetállam volt. Ez nem egy fekete kalapos hacker volt. Ez egy motivált elemző volt, aki nyilvánosan elérhető eszközöket használt egy fogyasztói GPU-n. A legfontosabb eszköz? Helyben hosztolt, korlátozások nélküli mesterséges intelligencia modellek. Az olyan platformokon, mint a Hugging Face, több mint egymillió nyílt forráskódú modell áll rendelkezésre, így a támadók hatalmas könyvtárból választhatnak, finomhangolhatják őket rosszindulatú célokra, és felügyelet nélkül futtathatják őket. A felhőalapú szolgáltatásokkal ellentétben a helyi LLM-ek átprogramozhatók, hogy figyelmen kívül hagyják a biztonsági intézkedéseket és támadó feladatokat hajtsanak végre.

"Ezt egy motivált amatőr is képes felépíteni. Képzeljük el, mire képes egy nemzetállam" - figyelmeztetett Martin. Példája azt mutatja, hogy a mesterséges intelligenciával való visszaélés hogyan alakíthatja át a kiberbűnözést képzett szakmából egy hozzáférhető, mesterséges intelligenciával támogatott munkafolyamatba. Ma már nem szűk keresztmetszet a rosszindulatú programok létrehozása. A felderítésnek gyorsabban kell fejlődnie, mint a támadóknak ma már a kezükben lévő eszközöknek.

Hogyan védekezzünk az AI-alapú kibertámadások ellen?

Többrétegű védelemre van szükségünk - nem csak okosabb észlelésre.

A rendszerek védelme az AI-alapú kibertámadások ellen többrétegű stratégiát igényel, amely az automatizálást az emberi rálátással, a megelőzést a felderítéssel kombinálja. A vezető AI-alapú kiberbiztonsági megoldások, mint például az OPSWATfejlett fenyegetésmegelőző platformja, integrálják a megelőzést és az észlelést. Nézze meg a videót, hogy többet megtudjon.

AI biztonsági tesztelés és Red Teaming

Sok szervezet fordul a mesterséges intelligencia által támogatott red teaminghez, hogy tesztelje az LLM visszaélések, prompt injection és osztályozó megkerülése elleni védelmét. Ezek a szimulációk segítenek a támadók előtt felfedni a mesterséges intelligenciával integrált rendszerek sebezhetőségeit.

A vörös csapatok ellenséges felszólításokat, szintetikus adathalászatot és mesterséges intelligencia által generált hasznos terheléseket használnak annak értékelésére, hogy a rendszerek ellenállóak vagy kihasználhatók-e. A mesterséges intelligencia alapú biztonsági tesztelés magában foglalja a következőket is:

- Fuzzing modellek prompt injekciós kockázatokra

- Annak értékelése, hogy az LLM-ek hogyan kezelik a manipulált vagy láncolt bemeneteket

- Az osztályozó robusztusságának tesztelése a kitérő viselkedéssel szemben

A biztonsági vezetők saját LLM-jeiket is elkezdik vizsgálni a prompt szivárgás, a hallucinációk vagy a belső logikához való nem szándékos hozzáférés szempontjából, ami kulcsfontosságú lépés, mivel a generatív AI beágyazódik a termékekbe és a munkafolyamatokba.

Egy okosabb védelmi rendszer: OPSWATmegközelítése

Martin Kallas ahelyett, hogy reaktív módon próbálna "mesterséges intelligencia ellen harcolni", egy többrétegű, proaktív védekezés mellett érvel. OPSWAT olyan technológiákat kombinálnak, amelyek a fenyegetések teljes életciklusát célozzák:

- Metascan™ Multiscanning: Futtatja a fájlokat több vírusirtó motoron keresztül az egy vírusirtó motoros rendszerek által nem észlelt fenyegetések felderítése érdekében.

- MetaDefender Sandbox™: Elemzi a fájlok viselkedését elszigetelt környezetben, még a statikus szabályokat megkerülő, mesterséges intelligencia által generált hasznos terheléseket is felismeri.

- Mély CDR™: Semlegesíti a fenyegetéseket azáltal, hogy a fájlokat biztonságos verziókká alakítja át, eltávolítva a beágyazott exploitokat.

Ezt a többszintű biztonsági csomagot úgy tervezték, hogy ellensúlyozza az AI által generált rosszindulatú programok kiszámíthatatlan természetét, beleértve a polimorf fenyegetéseket, a memórián belüli hasznos terheket és a hagyományos eszközöket megkerülő deepfake csalikat. Mivel minden réteg a támadási lánc különböző szakaszait veszi célba, elég egy a fenyegetés észleléséhez vagy semlegesítéséhez, és az egész művelet összeomlik, mielőtt az kárt okozhatna.

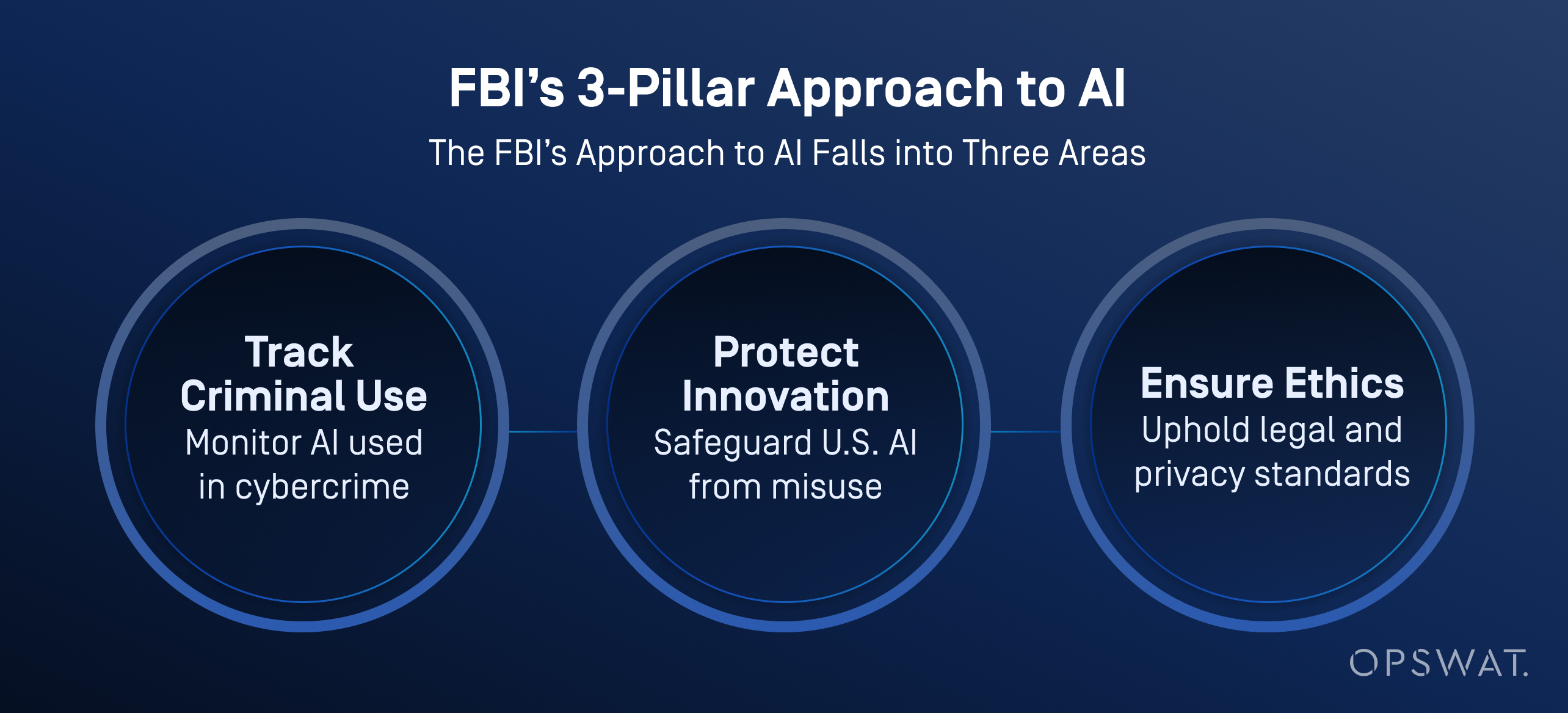

Ipari felhasználási esetek: Milyen mesterséges intelligenciát használ az FBI?

Az FBI és más amerikai ügynökségek egyre inkább integrálják a mesterséges intelligenciát kibervédelmi műveleteikbe, nemcsak a fenyegetések osztályozása és rangsorolása, hanem az adatelemzés, a videóelemzés és a hangfelismerés javítása érdekében is.

Az FBI szerint a mesterséges intelligencia nagy mennyiségű adat feldolgozását segíti a nyomozati nyomok előállításához, beleértve a járműfelismerést, a nyelvi azonosítást és a beszédből szöveggé alakítást. Fontos, hogy az iroda szigorú emberi felügyeletet biztosít: minden mesterséges intelligencia által generált eredményt képzett nyomozóknak kell ellenőrizniük, mielőtt bármilyen intézkedést hoznának.

A mesterséges intelligencia nem helyettesíti az emberi döntéshozatalt. Az FBI hangsúlyozza, hogy a nyomozás eredményeiért mindig az ember a felelős, és hogy a mesterséges intelligenciát a magánélet, a polgári szabadságjogok és a jogi normák tiszteletben tartásával kell alkalmazni.

Készen állnak a szervezetek?

A Ponemon " State of AI Cybersecurity Report" című jelentése szerint az AI által vezérelt fenyegetések növekedése ellenére a biztonsági szakembereknek csak 37%-a érzi magát felkészültnek egy AI-alapú kibertámadás megállítására. Sokan még mindig elavult kiberkockázat-kezelési tervekre és reaktív észlelési stratégiákra támaszkodnak.

A továbblépéshez 4 alapvető lépésre van szükség:

- Az AI-tudatos védelmi eszközök gyorsabb elfogadása

- Folyamatos red teaming és azonnali kockázati tesztelés

- Multiscanning, CDR és sandboxing aktív használata

- SOC elemzők képzése az automatizált vizsgálati eszközökkel való együttműködésre

Az AI megváltoztatta a szabályokat. Nem az emberek helyettesítéséről van szó, hanem arról, hogy olyan eszközöket adjunk nekik, amelyekkel megelőzhetik a támadásokat, amelyek most már önállóan gondolkodnak. Fedezze fel, hogyan segít platformunk a fájlok, eszközök és adatáramlások biztonságossá tételében az IT- és OT-környezetekben.

Gyakran ismételt kérdések (GYIK)

Mi az AI hacking?

Az AI hacking olyan eszközök, mint például a nagy nyelvi modellek (LLM) használata a kibertámadások automatizálására vagy fokozására. Segítségével a támadók a korábbinál gyorsabban és könnyebben hozhatnak létre rosszindulatú szoftvereket, indíthatnak adathalászkampányokat, és kerülhetik meg a védelmi rendszereket.

Hogyan használják a mesterséges intelligenciát a kiberbűnözéshez?

A bűnözők a mesterséges intelligenciát rosszindulatú programok létrehozására, adathalászat automatizálására és a sebezhetőségi vizsgálatok felgyorsítására használják. Egyes eszközök, például a sötét webes fórumokon árult eszközök még a teljes támadási láncon is végig tudják kísérni a támadókat.

Mi a különbség az AI hacking és a hagyományos hacking között?

A hagyományos hackeléshez gyakorlati kódolásra, eszközhasználatra és technikai készségekre van szükség. A mesterséges intelligenciával történő hackelés csökkenti ezt az akadályt olyan modellekkel, amelyek egyszerű kérésekből haszonterheket, szkripteket és adathalász tartalmakat generálnak. Ezek a technikák gyorsabbá, skálázhatóbbá és amatőrök számára is elérhetővé teszik a támadásokat.

Hogyan lehet visszaélni a mesterséges intelligenciával rosszindulatú programok kifejlesztésére?

A mesterséges intelligencia kevés ráfordítással képes polimorfikus rosszindulatú szoftvereket, fordított héjakat és homokozóban terjedő hasznos terheléseket generálni. Amint az az OPSWAT élő demójában is látható volt, egy nem rosszindulatú felhasználó két óra alatt közel nulladik napi malware-t hozott létre egy játékgépen futó nyílt forráskódú mesterséges intelligenciamodellek segítségével.

A mesterséges intelligencia helyettesítheti a hackereket?

Még nem, de számos technikai feladatot képes megoldani. A hackerek még mindig célpontokat és célokat választanak, míg a mesterséges intelligencia kódot ír, kikerüli az észlelést és adaptálja a támadásokat. Az igazi kockázatot az emberi támadók jelentik, akiket az AI sebessége felerősít.

Mi az az AI hacker?

Az AI hacker olyan személy vagy félautonóm rendszer, amely mesterséges intelligenciát használ kibertámadások indítására, rosszindulatú programok automatizálására vagy adathalász kampányok méretarányos futtatására.

Milyen mesterséges intelligenciát használ az FBI?

Az FBI mesterséges intelligenciát használ a fenyegetések osztályozására, törvényszéki elemzésre, anomáliák észlelésére és digitális bizonyítékok feldolgozására. Ezek az eszközök segítenek automatizálni a nyomozásokat és felszínre hozni a kiemelt fontosságú ügyeket, miközben csökkentik az elemzők munkaterhelését.

Mi a példa az AI támadásra?

Az egyik valós eset az AI által generált adathalász e-maileket érintette egy vállalat beiratkozási időszakában. A támadók a HR-esnek adták ki magukat, hogy ellopják a hitelesítő adatokat. Egy másik esetben a mesterséges intelligencia segített automatizálni a zsarolóvírusok célzását, ami arra kényszerített egy multinacionális márkát, hogy leállítsa működését.

Mik azok a mesterséges intelligencia kibertámadások?

A mesterséges intelligenciával végrehajtott kibertámadások olyan fenyegetések, amelyeket mesterséges intelligencia segítségével fejlesztettek ki vagy hajtottak végre. Ilyen például az AI által generált adathalászat, a deepfake megszemélyesítés, a prompt injection és az osztályozó kikerülése. Ezek a támadások gyakran megkerülik a hagyományos védelmet.

Hogyan használják a hackerek és a csalók a mesterséges intelligenciát az emberek megcélzására?

A hackerek mesterséges intelligenciát használnak az adathalász e-mailek személyre szabásához, a telefonos csalásokhoz hangok klónozásához, valamint a célpontok megtévesztéséhez deepfake videók létrehozásához. Ezek a taktikák kihasználják az emberi bizalmat, és még a jól képzett felhasználókat is sebezhetővé teszik a valósághű, mesterséges intelligenciával létrehozott megtévesztéssel szemben.

Hogyan védekezhetek a mesterséges intelligencia által vezérelt támadások ellen?

Használjon többrétegű védelmet: Multiscanning, sandboxing, CDR és ember által vezetett red teaming. Az AI-támadások gyorsan mozognak. A védőknek automatizálásra, kontextusra és sebességre van szükségük, hogy lépést tudjanak tartani.